Il était pas loin de 19 h 30 à la Fête de l’Humanité, ce 17 septembre 2023, quand Angèle a expliqué à son public : « Ce matin, je me suis dit : “Et pourquoi je ne ferais pas ce que les gens me demandent depuis des semaines ?” » Et elle s’est lancée dans une reprise de Saiyan, un tube rap de Gazo et Heuss l’Enfoiré pourtant bien loin de sa pop acide. La foule est devenue folle d’un coup, excitée par ce qui est devenu l’un des moments musicaux les plus marquants de l’année 2023 parce que cette reprise insouciante signait l’entrée du clonage vocal par intelligence artificielle dans la musique populaire en France.

Car, avant qu’Angèle ne se saisisse de ce Saiyan, c’est sa voix qu’a utilisée un certain Lnkhey sur YouTube pour lui faire reprendre la chanson et encaisser plus d’un million de vues en même pas deux mois. Et on est très loin d’un robot qui chante : c’est une vraie chanson d’Angèle, mais sans Angèle. La voix est précise, l’intonation est là, le souffle aussi. C’est le début d’une nouvelle révolution dans laquelle le monde de la musique commence à entrer à pas mesurés, comme on rentre dans un bain encore trop chaud. Parce qu’il y a certainement beaucoup à y gagner, mais aussi beaucoup d’erreurs à commettre avec le clonage vocal, qui laisse déjà entrevoir la possibilité pour les artistes de chanter en plusieurs langues mais aussi la renaissance de voix décédées pour les essorer même dans la mort.

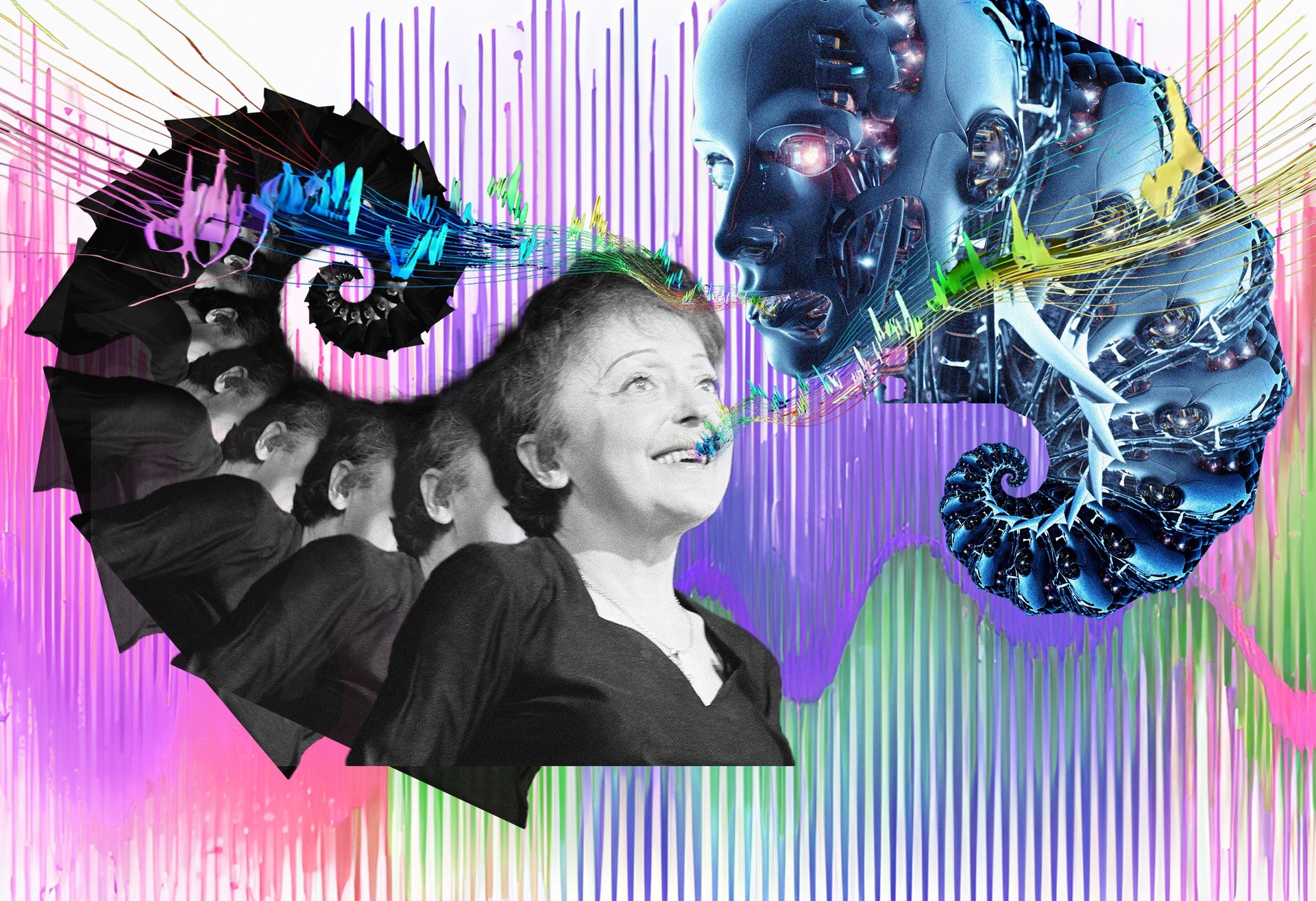

C’est ainsi que Warner Music, l’une des trois majors internationales du disque, a annoncé en novembre qu’un film d’animation sur la vie et la musique d’Édith Piaf sera narré par Piaf elle-même. Ou plutôt par son clone vocal, chargé de faire revenir la chanteuse morte en 1963, à 47 ans. Pour l’instant, il ne s’agit pas de recréer la voix chantée de la Môme, mais de se contenter de son parler du Paris populaire de l’entre-deux-guerres. « Dès le début de ce projet, raconte Julie Veille, la cofondatrice du studio parisien Seriously Happy qui en est à l’origine, on s’est dit : “Qui mieux qu’Édith Piaf pour raconter son histoire ?” On ne voulait pas que ce soit une comédienne, ou utiliser des interviews d’époque qui, de toute façon, ne sont pas assez nombreuses. C’est là que Warner Music nous a dit qu’ils travaillaient sur plusieurs techniques qui permettent de reproduire des voix. »

Warner, qui représente les enregistrements historiques d’Édith Piaf comme La Vie en rose, La Foule ou Non, je ne regrette rien, vient en effet de publier

Cette technologie de la séparation des sources par intelligence artificielle est aujourd’hui parfaitement au point, et c’est cette accélération soudaine qui est à son tour la clé de la révolution du clonage vocal qui s’élance. Axel Roebel est directeur de recherche à l’Ircam, le centre de recherche parisien pionnier dans la jonction entre l’informatique et la musique. Il a « clairement vu une accélération récente dans le secteur du traitement du signal sonore, notamment parce qu’on dispose désormais de bases de données assez énormes de voix qui servent de référence pour éduquer les réseaux de neurones. C’est une clé, parce qu’on ne peut pas cloner une voix si elle est mixée à des instruments ou s’il y a du bruit autour, parce que la machine va penser que cela fait partie de la voix ou trop s’éparpiller. » C’est avec cette idée de la séparation des pistes sonores qu’Axel Roebel était allé voir des maisons de disques il y a six ans déjà, pour leur présenter ces technologies prometteuses. « Je pensais qu’elles seraient intéressées, se rappelle-t-il, mais elles nous ont dit : “Non, c’est dangereux.” Il y avait chez elles la peur que ce ne soit pas bien vu par le public. »

Ces barrières ont sauté aujourd’hui, dans le secteur de la musique comme dans le cinéma. Ces dernières années, Axel Roebel et l’Ircam ont ainsi recréé les voix des acteurs du procès du maréchal Pétain pour un documentaire en 2015, celle du général de Gaulle lançant son appel du 18 Juin dont il ne reste pourtant aucune trace sonore, ou encore la voix de Louis de Funès pour un personnage du film Pourquoi j’ai pas mangé mon père. C’est aussi l’Ircam qui a travaillé avec Thierry Ardisson pour l’émission Hôtel du temps, qui utilise l’IA pour faire discuter l’animateur avec Jean Gabin ou Dalida, en essayant de retrouver leur phrasé si particulier.

Au fil de ces expérimentations qui ont fait pénétrer l’IA dans le quotidien télévisuel, tout s’est sans cesse accéléré techniquement. Surtout, la masse de données nécessaire au clonage d’une voix s’est sérieusement réduite. Pour le film consacré à Édith Piaf, l’entreprise ukrainienne Respeecher, l’un des leaders de l’IA appliquée aux arts, a « utilisé des sources audio vieilles de 80 ans, c’est il y a très longtemps, m’a expliqué Alex Serdiuk, son fondateur. Et c’étaient des séquences très courtes, quelque chose comme quarante secondes. C’est très peu, d’habitude on travaille avec trente minutes de matière pour être confortables ». Mais ça, c’est la version très professionnelle, exigeante et qualitative du clonage. Certains outils accessibles à tous, comme Covers.ai, permettent pour leur part d’obtenir une voix imparfaite mais qui fait complètement illusion avec quelques minutes d’enregistrement à peine. Et tous les spécialistes consultés pour cette enquête pensent qu’on va très rapidement tomber sous la minute, parce que les modèles vocaux connaissent désormais tellement bien les mécanismes du langage humain qu’ils n’ont plus besoin que d’une enveloppe de timbre pour imiter une voix très facilement.

Avec ces technologies, on arrive à avoir le bon timbre de voix mais pas l’intonation et la prosodie. On a donc développé l’idée d’utiliser des acteurs et des actrices qui interprètent le texte, avant que l’on remplace leur voix par la voix cible.

Reste quand même une grosse difficulté sur laquelle bute encore le clonage vocal : « Avec ces technologies, on arrive à avoir le bon timbre de voix mais pas l’intonation et la prosodie », explique Axel Roebel. Il manque la personnalité de la voix, cette façon si humaine de poser les syllabes, les respirations et les infinies nuances vocales. « On a donc développé l’idée d’utiliser des acteurs et des actrices qui interprètent le texte, avant que l’on remplace leur voix par la voix cible. C’est un peu comme la motion capture au cinéma, où on utilise les mouvements d’un acteur pour faire un autre personnage. » Pour son film sur Édith Piaf, Julie Veille a elle aussi été confrontée à cette limite actuelle des technologies d’intelligence artificielle appliquées à la voix. « Dans ce que j’ai pu voir, il est clair que rien ne remplace à ce jour l’émotion et le jeu d’un acteur, tranche-t-elle. Je ne sais pas si dans quelques années, les comédiens seront remplacés, mais je ne vois pas aujourd’hui comment une machine pourrait recréer l’émotion que véhicule une personne. » Chez Respeecher, Alex Serdiuk estime que « théoriquement, on peut imaginer qu’une machine donne des émotions, mais ce ne sera qu’une copie, pas l’équivalent du jeu d’une vraie personne. Une machine ne peut pas aller plus loin que ce qu’elle imite ».

Ce n’est d’ailleurs qu’une quête secondaire aujourd’hui, tant l’IA et le clonage vocal s’annoncent aussi comme des outils de créativité supplémentaires capables de démultiplier les idées des artistes et ne seront pas qu’une foire aux idées lucratives qui ne manqueront pas d’envahir les plateformes ces prochaines années. Ces technologies pourraient même avoir pour conséquence de remettre les artistes les plus inventifs en avant car, en donnant à tout le monde des outils qui permettent de reproduire des musiques très facilement, il va devenir bien moins intéressant de sortir des chansons qui ressemblent à d’autres. « On ne va pas remplacer les artistes, avertit ainsi Michael Turbot, qui est « technology promotion manager » au sein du laboratoire Sony CSL du géant de l’électronique. Il faut plutôt que les maisons de disques embauchent plein de directeurs artistiques pour encaisser cette demande de créativité et donc de nouveaux artistes humains à identifier et signer. » C’est ce que racontent déjà les derniers mois de la musique, où Angèle n’est pas la seule à avoir été chahutée par le clonage vocal. À tel point que c’est aujourd’hui l’industrie de la musique qui doit lui courir après.